“

Supón que entras en una habitación oscura de un edificio desconocido. Podrías sentir pánico ante los monstruos que podrían estar acechando en la oscuridad. O podrías simplemente encender la luz, para evitar chocar con los muebles. La habitación oscura es el futuro de la inteligencia artificial (IA). Por desgracia, mucha gente cree que, al entrar en la habitación, podríamos toparnos con máquinas malvadas y ultrainteligentes. Se trata de un temor antiguo. Se remonta a la década de 1960, cuando Irving John Good, un matemático británico que trabajó como criptólogo en Bletchley Park con Alan Turing, hizo la siguiente observación:

La Inteligencia Artificial no es una máquina.

Definamos una máquina ultrainteligente como una máquina que puede superar con creces todas las actividades intelectuales de cualquier hombre por inteligente que sea. Puesto que el diseño de máquinas es una de estas actividades intelectuales, una máquina ultrainteligente podría diseñar máquinas aún mejores; entonces se produciría incuestionablemente una “explosión de inteligencia”, y la inteligencia del hombre quedaría muy atrás. Así pues, la primera máquina ultrainteligente es el último invento que el hombre necesita hacer, siempre que la máquina sea lo suficientemente dócil como para decirnos cómo mantenerla bajo control. Es curioso que este punto se plantee tan pocas veces fuera de la ciencia ficción. A veces merece la pena tomarse en serio la ciencia ficción.

Una vez que las máquinas ultrainteligentes se hagan realidad, puede que no sean en absoluto dóciles, sino que se comporten como Terminator: esclavizar a la humanidad como una subespecie, ignorar sus derechos y perseguir sus propios fines, independientemente de los efectos sobre las vidas humanas.

Si esto te parece increíble, quizá quieras reconsiderarlo. Avancemos medio siglo hasta ahora, y los asombrosos avances de nuestras tecnologías digitales han llevado a mucha gente a creer que la “explosión de inteligencia” del Bien es un grave riesgo, y que el fin de nuestra especie podría estar cerca, si no tenemos cuidado. Éste es Stephen Hawking en 2014:

El desarrollo de la inteligencia artificial completa podría significar el fin de la raza humana.

El año pasado, Bill Gates era de la misma opinión:

Estoy en el bando de los preocupados por la superinteligencia. En primer lugar, las máquinas harán muchos trabajos por nosotros y no serán superinteligentes. Eso debería ser positivo si lo gestionamos bien. Sin embargo, unas décadas después, la inteligencia será lo suficientemente fuerte como para ser motivo de preocupación. Estoy de acuerdo con Elon Musk y algunos otros en esto, y no entiendo por qué algunas personas no están preocupadas.

¿Y qué había dicho Musk, el director general de Tesla?

Debemos tener mucho cuidado con la inteligencia artificial. Si tuviera que adivinar cuál es nuestra mayor amenaza existencial, probablemente sería que… Cada vez más, los científicos piensan que debería haber algún tipo de supervisión reguladora, quizá a nivel nacional e internacional, sólo para asegurarnos de que no hacemos algo muy insensato. Con la inteligencia artificial, estamos invocando al demonio. En todas esas historias en las que aparece el tipo con el pentagrama y el agua bendita, es como si estuviera seguro de poder controlar al demonio. No funcionó.

La realidad es más trivial. Este mes de marzo, Microsoft introdujo Tay -un robot de chat basado en IA- en Twitter. Tuvieron que retirarlo sólo 16 horas después. Se suponía que se volvería cada vez más inteligente a medida que interactuara con los humanos. En lugar de eso, se convirtió rápidamente en un malvado charlatán amante de Hitler, negador del Holocausto, promotor del sexo incestuoso y que proclamaba que “Bush hizo el 11-S”. ¿Por qué? Porque no funcionaba mejor que el papel de cocina, absorbiendo y siendo moldeado por los desagradables mensajes que se le enviaban. Microsoft se disculpó.

Este es el estado actual de la IA. Después de tanto hablar de los riesgos de las máquinas ultrainteligentes, ha llegado el momento de encender la luz, dejar de preocuparnos por escenarios de ciencia ficción y empezar a centrarnos en los retos reales de la IA, para evitar cometer errores dolorosos y costosos en el diseño y uso de nuestras tecnologías inteligentes.

Déjame ser más específico. A la filosofía no se le dan bien los matices. Puede que se precie de ser un modelo de precisión y distinciones muy afinadas, pero lo que realmente le encanta son las polarizaciones y dicotomías. Internalismo o externalismo, fundacionalismo o coherentismo, carro a la izquierda o a la derecha, zombis o no zombis, observador-relativo u observador-independiente, mundos posibles o imposibles, fundamentados o no fundamentados… La filosofía puede predicar el vel inclusivo (“las niñas o los niños pueden jugar”), pero con demasiada frecuencia se entrega al aut aut excluyente (“o te gusta o no te gusta”).

El debate actual sobre la IA es un ejemplo de ello. Aquí, la dicotomía es entre los que creen en la verdadera IA y los que no. Sí, la verdadera, no Siri en tu iPhone, Roomba en tu salón o Nest en tu cocina (soy feliz propietario de las tres). Piensa en la falsa María en Metrópolis (1927); Hal 9000 en 2001: Una Odisea del Espacio (1968), en la que Good fue uno de los asesores; C3PO en La Guerra de las Galaxias (1977); Rachael en Blade Runner (1982); Data en Star Trek: The Next Generation (1987); el agente Smith en The Matrix (1999) o la incorpórea Samantha en Her (2013). Ya te haces una idea. Los creyentes en la verdadera IA y en la “explosión de inteligencia” de Good pertenecen a la Iglesia de los Singularitarios. A falta de un término mejor, me referiré a los incrédulos como miembros de la Iglesia de los Ateístas. Echemos un vistazo a ambas creencias y veamos por qué ambas están equivocadas. Y mientras tanto, recuerda: la buena filosofía casi siempre está en el aburrido término medio.

Singularistas creen en tres dogmas. Primero, que la creación de alguna forma de ultrainteligencia artificial es probable en un futuro previsible. Este punto de inflexión se conoce como singularidad tecnológica, de ahí su nombre. Tanto la naturaleza de dicha superinteligencia como el marco temporal exacto de su llegada quedan sin especificar, aunque los Singularistas tienden a preferir futuros que estén lo suficientemente cerca como para preocuparse, pero lo suficientemente lejos como para que no se demuestre que están equivocados.

En segundo lugar, la humanidad corre un gran riesgo de ser dominada por dicha ultrainteligencia. En tercer lugar, una responsabilidad primordial de la generación actual es garantizar que la Singularidad no se produzca o, si se produce, que sea benigna y beneficie a la humanidad. Esto tiene todos los elementos de una visión maniquea del mundo: El Bien contra el Mal, connotaciones apocalípticas, la urgencia de “debemos hacer algo ahora o será demasiado tarde”, una perspectiva escatológica de la salvación humana y una apelación a los miedos y a la ignorancia.

Pero todo esto no es lo mismo que una visión maniquea del mundo.

Pon todo esto en un contexto en el que la gente está preocupada, y con razón, por el impacto de las estúpidas tecnologías digitales en sus vidas, especialmente en el mercado laboral y en las ciberguerras, y en el que los medios de comunicación informan a diario sobre nuevos artilugios y desastres informáticos sin precedentes, y tienes una receta para la distracción masiva: un opiáceo digital para las masas.

Como todas las opiniones basadas en la fe, el Singularitarismo es irrefutable porque, en definitiva, no está limitado por la razón ni las pruebas. También es inverosímil, ya que no hay motivos para creer que vaya a surgir nada parecido a máquinas inteligentes (por no hablar de ultrainteligentes) a partir de nuestra comprensión actual y previsible de la informática y las tecnologías digitales. Me explico:

A veces, el Singularitarismo se presenta de forma condicional. Esto es astuto, porque el entonces sí se sigue del si, y no meramente en un sentido ex falso quodlibet: si apareciera algún tipo de ultrainteligencia, entonces estaríamos en serios problemas (no sólo “podríamos”, como afirma Hawking más arriba). Correcto. Totalmente. Pero esto también es válido para el siguiente condicional: si aparecieran los Cuatro Jinetes del Apocalipsis, entonces estaríamos en un lío aún más grave.

En otras ocasiones, podríamos estar en un lío aún más grave.

En otras ocasiones, el Singularitarismo se basa en un sentido muy débil de la posibilidad: alguna forma de ultrainteligencia artificial podría desarrollarse, ¿no? Sí, podría. Pero este “podría” es una mera posibilidad lógica: por lo que sabemos, no hay contradicción alguna en suponer el desarrollo de la ultrainteligencia artificial. Sin embargo, se trata de un truco, que difumina la inmensa diferencia entre “podría estar enfermo mañana” cuando ya me encuentro mal, y “podría ser una mariposa que sueña que es un ser humano”.

Sigue sin estar claro cómo podría evolucionar de forma autónoma una IA asquerosamente ultrainteligente a partir de las habilidades computacionales necesarias para aparcar en un sitio estrecho

Puedo ser una mariposa que sueña con ser un ser humano.

No hay ninguna contradicción en suponer que un pariente muerto del que nunca has oído hablar te ha dejado 10 millones de dólares. Eso podría ocurrir. ¿Y qué? Las contradicciones, como los solteros felizmente casados, no son estados de cosas posibles, pero las no contradicciones, como los agentes extraterrestres que viven entre nosotros tan bien ocultos que nunca los descubrimos, aún pueden descartarse como una completa locura. En otras palabras, el “podría” no es el “podría ocurrir” de un terremoto, sino el “no es cierto que no podría ocurrir” de pensar que eres el primer humano inmortal. Correcto, pero no una razón para empezar a actuar como si fueras a vivir eternamente. A no ser que alguien aporte pruebas de lo contrario y demuestre que hay algo en nuestra comprensión actual y previsible de la informática que debería hacernos sospechar que la aparición de la ultrainteligencia artificial es realmente plausible.

Aquí los Singularitarios mezclan fe y hechos, a menudo movidos, creo, por una sincera sensación de urgencia apocalíptica. Empiezan hablando de pérdidas de empleo, sistemas digitales en peligro, drones no tripulados que salen mal y otras cuestiones reales y preocupantes sobre las tecnologías computacionales que están llegando a dominar la vida humana, desde la educación al empleo, desde el entretenimiento a los conflictos. De ahí pasan a estar seriamente preocupados por su incapacidad para controlar su próximo Honda Civic porque tendrá mente propia. Sigue sin estar claro cómo alguna IA ultrainteligente y repugnante evolucionará alguna vez de forma autónoma a partir de las habilidades computacionales necesarias para aparcar en un sitio estrecho. Lo cierto es que subirse a lo alto de un árbol no es un pequeño paso hacia la Luna; es el final del viaje. Lo que vamos a ver son máquinas cada vez más inteligentes capaces de realizar más tareas que las que actualmente realizamos nosotros mismos.

Si todos los demás argumentos fallan, a los Singularistas les gusta echar mano de las matemáticas. Una de sus referencias favoritas es la Ley de Moore. Se trata de la afirmación empírica de que, en el desarrollo de los ordenadores digitales, el número de transistores en los circuitos integrados se duplica aproximadamente cada dos años. El resultado ha sido hasta ahora más potencia de cálculo por menos. Pero las cosas están cambiando. Las dificultades técnicas de la nanotecnología plantean graves problemas de fabricación. Al fin y al cabo, hay un límite a lo pequeñas que pueden llegar a ser las cosas antes de fundirse. La Ley de Moore ya no es válida. El hecho de que algo crezca exponencialmente durante algún tiempo no significa que vaya a seguir haciéndolo para siempre, como dijo The Economist en 2014:

La Ley de Moore ya no es válida.

A lo largo de la historia, los seres humanos han reinado sin oposición como la especie dominante de la Tierra. ¿Podría cambiar pronto? Los pavos, criaturas hasta ahora inofensivas, han aumentado de tamaño, pasando de una media de 6 kg (13,2 lb) en 1929 a más de 15 kg (30 lb) en la actualidad. Partiendo de la sólida hipótesis científica de que las tendencias actuales persistirán, The Economist calcula que los pavos serán tan grandes como los humanos en sólo 150 años. Dentro de 6.000 años, los pavos empequeñecerán todo el planeta. Los científicos afirman que el rápido crecimiento de los pavos es el resultado de innovaciones en la avicultura, como la cría selectiva y la inseminación artificial. La naturaleza artificial de su crecimiento, y el hecho de que la mayoría haya perdido la capacidad de volar, sugieren que no todo está perdido. Aun así, con casi 250 millones de pavos engullendo y desfilando sólo en Estados Unidos, hay motivos de preocupación. Este Día de Acción de Gracias, sólo hay una medida prudente: comértelos antes de que te coman a ti.

De Turkzilla a AIzilla, el paso es pequeño, si no fuera porque una curva de crecimiento puede ser fácilmente sigmoidea, con una fase inicial de crecimiento aproximadamente exponencial, seguida de saturación, crecimiento más lento, madurez y, finalmente, ningún crecimiento más. Pero sospecho que la representación de curvas sigmoides puede resultar blasfema para los Singularitaristas.

El Singularitarismo es una distracción irresponsable. Es una preocupación del mundo rico, susceptible de preocupar a las personas de las sociedades acomodadas, que parecen olvidarse de los males reales que oprimen a la humanidad y a nuestro planeta. Baste un ejemplo: casi 700 millones de personas no tienen acceso al agua potable. Se trata de una gran amenaza para la humanidad. Ah, y por si pensabas que las predicciones de los expertos eran una guía fiable, piénsatelo dos veces. Hay muchas predicciones tecnológicas asombrosamente erróneas de expertos (véanse algunas divertidísimas de David Pogue y en cracked.com). En 2004, Gates declaró: ‘Dentro de dos años, el spam estará resuelto’. Y en 2011 Hawking declaró que “la filosofía ha muerto” (¿qué es esto que estás leyendo?).

La predicción a la que más cariño tengo es la de Robert Metcalfe, coinventor de Ethernet y fundador del fabricante de electrónica digital 3Com. En 1995 prometió “comerse sus palabras” si se demostraba que estaba equivocado al afirmar que “Internet pronto se convertirá en una supernova y en 1996 se derrumbará catastróficamente”. Hombre de palabra, en 1997 licuó públicamente su artículo en un robot de cocina y se lo bebió. Ojalá los Singularitarios fueran tan audaces y coherentes como él.

Dprofundamente irritados por los que adoran a los dioses digitales equivocados, y por sus profecías Singularitarias incumplidas, los incrédulos -AIteístas- tienen como misión demostrar de una vez por todas que cualquier tipo de fe en la verdadera IA es totalmente errónea. La IA no son más que ordenadores, los ordenadores no son más que Máquinas de Turing, las Máquinas de Turing no son más que motores sintácticos, y los motores sintácticos no pueden pensar, no pueden saber, no pueden ser conscientes. Fin de la historia.

Por eso hay tantas cosas que los ordenadores (todavía) no pueden hacer, a grandes rasgos el título de varias publicaciones – Ira Wilson (1970); Hubert Dreyfus (1972; 1979); Dreyfus (1992); David Harel (2000); John Searle (2014) – aunque lo que precisamente no pueden hacer es un objetivo convenientemente móvil. También es la razón por la que son incapaces de procesar la semántica (de cualquier idioma, chino incluido, no importa lo que consiga la traducción de Google). Esto demuestra que no hay absolutamente nada que discutir, y mucho menos de lo que preocuparse. No existe una auténtica IA, así que a fortiori no hay problemas causados por ella. Relájate y disfruta de todos estos maravillosos artilugios eléctricos.

La fe de los Iteístas está tan fuera de lugar como la de los Singularistas. Ambas Iglesias tienen muchos seguidores en California, donde florecen paralelamente películas de ciencia ficción de Hollywood, maravillosas universidades de investigación como Berkeley y algunas de las empresas digitales más importantes del mundo. Puede que esto no sea casual. Cuando hay mucho dinero de por medio, la gente se confunde fácilmente. Por ejemplo, Google ha estado comprando empresas de tecnología de IA como si no hubiera un mañana (descargo de responsabilidad: soy miembro del Consejo Asesor de Google sobre el derecho a ser olvidado), así que seguramente Google debe saber algo sobre las posibilidades reales de desarrollar un ordenador que pueda pensar, que nosotros, fuera de “El Círculo”, nos estamos perdiendo. Eric Schmidt, presidente ejecutivo de Google, alimentó esta opinión cuando declaró al Instituto Aspen en 2013:

“Mucha gente en el campo de la IA cree que estamos cerca de que [un ordenador supere el test de Turing] en los próximos cinco años.

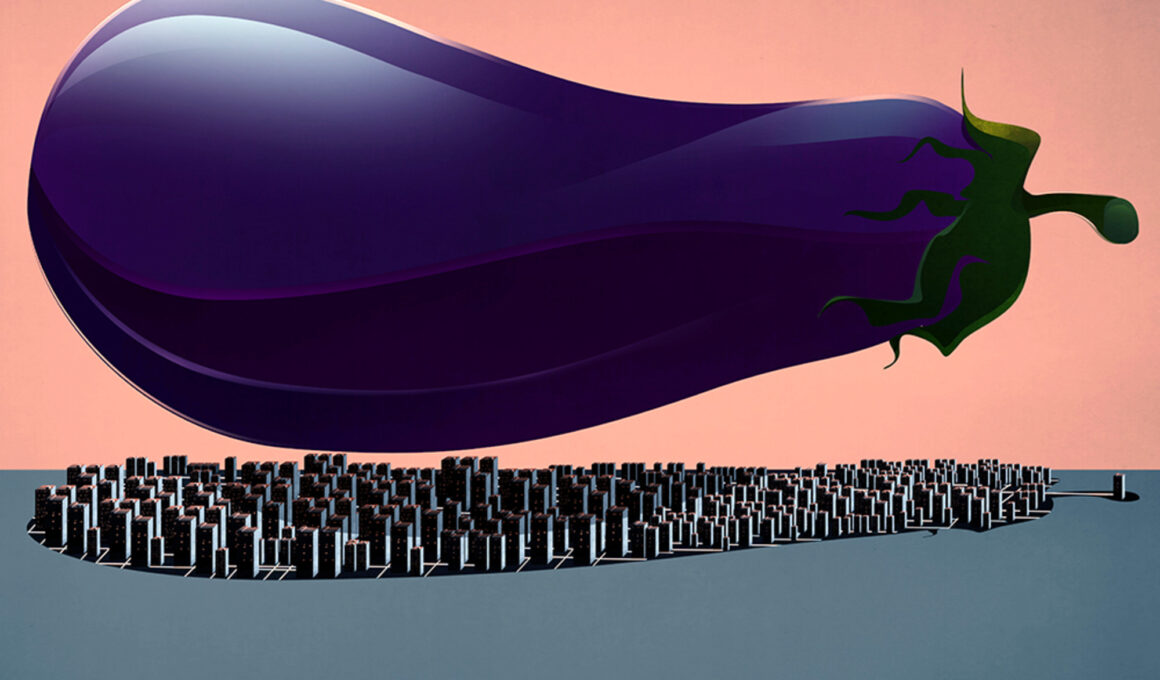

La prueba de Turing es una forma de comprobar si la IA está cada vez más cerca. Haces preguntas a dos agentes en otra habitación; uno es humano y el otro artificial; si no puedes distinguir entre los dos a partir de sus respuestas, entonces el robot supera la prueba. Es una prueba burda. Piensa en el examen de conducir: si Alice no lo supera, no es una conductora segura; pero incluso si lo supera, podría seguir siendo una conductora insegura. El test de Turing proporciona una condición necesaria pero insuficiente para una forma de inteligencia. Es un listón muy bajo. Y, sin embargo, ninguna IA lo ha superado. Y lo que es más importante, todos los programas siguen fallando de la misma manera, utilizando trucos desarrollados en los años 60. Permíteme hacer una apuesta. Odio la berenjena, pero me comeré un plato si un programa de software supera el test de Turing y gana la medalla de oro del Premio Loebner antes del 16 de julio de 2018. Es una apuesta segura.

Tanto los Singularistas como los IAteístas se equivocan. Como Turing afirmó claramente en el artículo de 1950 que introdujo su prueba, la pregunta “¿Puede pensar una máquina?” es “demasiado insignificante para merecer discusión”. (Irónicamente, o tal vez prescientemente, esa pregunta está grabada en la medalla del Premio Loebner). Esto es cierto, independientemente de a cuál de las dos Iglesias pertenezcas. Sin embargo, ambas Iglesias continúan este debate inútil, sofocando cualquier voz disidente de la razón.

La verdadera IA no es lógicamente imposible, pero es totalmente inverosímil. No tenemos ni idea de cómo podríamos empezar a diseñarla, entre otras cosas porque comprendemos muy poco cómo funcionan nuestro cerebro y nuestra inteligencia. Esto significa que no debemos perder el sueño por la posible aparición de alguna ultrainteligencia. Lo que realmente importa es que la presencia cada vez mayor de tecnologías cada vez más inteligentes está teniendo enormes efectos sobre cómo nos concebimos a nosotros mismos, el mundo y nuestras interacciones. No se trata de que nuestras máquinas sean conscientes, o inteligentes, o capaces de saber algo como nosotros. No lo son. Hay muchos resultados conocidos que indican los límites de la computación, los llamados problemas indecidibles, para los que se puede demostrar que es imposible construir un algoritmo que siempre conduzca a una respuesta correcta de sí o no.

Sabemos, por ejemplo, que nuestras máquinas de computación satisfacen la correspondencia Curry-Howard, que indica que los sistemas de prueba en lógica, por un lado, y los modelos de computación, por otro, son de hecho estructuralmente el mismo tipo de objetos, por lo que cualquier límite lógico se aplica también a los ordenadores. Muchas máquinas pueden hacer cosas asombrosas, como jugar a las damas, al ajedrez, al Go o al concurso Jeopardy mejor que nosotros. Y, sin embargo, todas ellas son versiones de una Máquina de Turing, un modelo abstracto que establece los límites de lo que puede hacer un ordenador a través de su lógica matemática.

Los ordenadores cuánticos son más inteligentes que nosotros.

Los ordenadores cuánticos están constreñidos por los mismos límites, los límites de lo que se puede computar (las llamadas funciones computables). No va a surgir ninguna entidad consciente e inteligente de una Máquina de Turing. La cuestión es que nuestras tecnologías inteligentes -también gracias a la enorme cantidad de datos disponibles y a una programación muy sofisticada- son cada vez más capaces de realizar más tareas mejor que nosotros, incluida la predicción de nuestros comportamientos. Así que no somos los únicos agentes capaces de realizar tareas con éxito.

Esto es lo que he definido como la Cuarta Revolución en nuestra autocomprensión. No somos el centro del Universo (Copérnico), del reino biológico (Charles Darwin) ni de la racionalidad (Sigmund Freud). Y después de Turing, tampoco estamos en el centro de la infosfera, el mundo del procesamiento de la información y la agencia inteligente. Compartimos la infosfera con las tecnologías digitales. Son artefactos corrientes que nos superan en cada vez más tareas, a pesar de no ser más inteligentes que una tostadora. Sus capacidades son humillantes y nos hacen reevaluar la excepcionalidad humana y nuestro papel especial en el Universo, que sigue siendo único. Pensábamos que éramos inteligentes porque sabíamos jugar al ajedrez. Ahora un teléfono juega mejor que un Gran Maestro. Nos creíamos libres porque podíamos comprar lo que quisiéramos. Ahora nuestros patrones de gasto son predichos por dispositivos tan gruesos como un tablón.

¿Cuál es la diferencia? La misma que hay entre tú y el lavavajillas al fregar los platos. ¿Cuál es la consecuencia? Que se puede despreciar cualquier visión apocalíptica de la IA

El éxito de nuestras tecnologías depende en gran medida del hecho de que, mientras especulábamos sobre la posibilidad de la ultrainteligencia, envolvimos cada vez más el mundo en tantos dispositivos, sensores, aplicaciones y datos que se convirtió en un entorno favorable a las TI, en el que las tecnologías pueden sustituirnos sin tener ningún tipo de comprensión, estados mentales, intenciones, interpretaciones, estados emocionales, habilidades semánticas, conciencia, autoconciencia o inteligencia flexible. La memoria (en forma de algoritmos e inmensos conjuntos de datos) supera a la inteligencia a la hora de aterrizar un avión, encontrar la ruta más rápida de casa a la oficina o descubrir el mejor precio para tu próximo frigorífico.

Las tecnologías digitales nos pueden sustituir en cualquier momento.

Las tecnologías digitales pueden hacer cada vez más cosas mejor que nosotros, procesando cantidades cada vez mayores de datos y mejorando su rendimiento analizando su propio resultado como entrada para las siguientes operaciones. AlphaGo, el programa informático desarrollado por Google DeepMind, ganó el juego de mesa Go contra el mejor jugador del mundo porque podía utilizar una base de datos de unos 30 millones de movimientos y jugar miles de partidas contra sí mismo, “aprendiendo” a mejorar su rendimiento. Es como un sistema de dos cuchillos que puede afilarse a sí mismo. ¿Cuál es la diferencia? La misma que hay entre tú y el lavavajillas al fregar los platos. ¿Cuál es la consecuencia? Que se puede descartar cualquier visión apocalíptica de la IA. Nosotros somos y seguiremos siendo, en un futuro previsible, el problema, no nuestra tecnología. Así que deberíamos concentrarnos en los verdaderos retos. A modo de conclusión, permíteme enumerar cinco de ellos, todos igual de importantes.

Debemos hacer que la IA sea respetuosa con el medio ambiente. Necesitamos las tecnologías más inteligentes que podamos construir para hacer frente a los males concretos que oprimen a la humanidad y a nuestro planeta, desde los desastres medioambientales a las crisis financieras, desde la delincuencia, el terrorismo y la guerra, a la hambruna, la pobreza, la ignorancia, la desigualdad y los pésimos niveles de vida.

Debemos hacer que la IA sea respetuosa con el medio ambiente.

Deberíamos hacer que la IA sea respetuosa con el ser humano. Debería usarse para tratar a las personas siempre como fines, nunca como meros medios, parafraseando a Immanuel Kant.

Deberíamos hacer que la estupidez de la IA beneficie a la inteligencia humana. Millones de puestos de trabajo se verán perturbados, eliminados y creados; los beneficios de ello deben ser compartidos por todos, y los costes, asumidos por la sociedad.

Debemos hacer que la inteligencia artificial funcione a favor de la inteligencia humana.

Deberíamos hacer que el poder predictivo de la IA trabaje a favor de la libertad y la autonomía. La comercialización de productos, la influencia en los comportamientos, la orientación de las personas o la lucha contra la delincuencia y el terrorismo nunca deben menoscabar la dignidad humana.

Y por último, debemos hacer que la IA nos haga más humanos. El grave riesgo es que hagamos un mal uso de nuestras tecnologías inteligentes, en detrimento de la mayor parte de la humanidad y de todo el planeta. Winston Churchill dijo que “damos forma a nuestros edificios y después nuestros edificios nos dan forma a nosotros”. Esto se aplica también a la infoesfera y a sus tecnologías inteligentes.

Los simularitarianos y los ateos de la IA seguirán con sus diatribas sobre la posibilidad o imposibilidad de una verdadera IA. Debemos ser tolerantes. Pero no tenemos por qué comprometernos. Como sugiere Virgilio en el Inferno de Dante: “No hables de ellos, sino mira y pasa de largo”. Porque el mundo necesita algo de buena filosofía, y nosotros tenemos que ocuparnos de problemas más acuciantes.

”

•••

es catedrático de Filosofía y Ética de la Información en la Universidad de Oxford, e Investigador Distinguido en el Centro Uehiro de Ética Práctica. Su último libro es La Cuarta Revolución: How the Infosphere Is Reshaping Human Reality (2014).