“

Para el filósofo francés Paul Virilio, el desarrollo tecnológico es indisociable de la idea de accidente. Según él, cada accidente es “un milagro invertido… Cuando se inventa el barco, también se inventa el naufragio; cuando se inventa el avión, también se inventa el accidente aéreo; y cuando se inventa la electricidad, se inventa la electrocución”. Los accidentes marcan los puntos en los que la anticipación se encontró con la realidad y salió peor parada. Sin embargo, cada uno de ellos es también una chispa de revelación secular: una oportunidad de superar el pasado, de hacer que lo peor de mañana sea mejor que lo de hoy y, en ocasiones, de prometer “nunca más”.

Este, al menos, es el plan. Nunca más” es una promesa difícil de cumplir: a largo plazo, no es cuestión de si las cosas van mal, sino de cuándo. Por tanto, las preocupaciones éticas de la innovación tienden a centrarse en la minimización y mitigación del daño, no en la ausencia total de daño. Un barco de vapor de doble casco supone menos riesgo por milla recorrida por un pasajero que un buque mercante medieval; una fábrica bien gestionada es más segura que un taller de explotación. Los accidentes aéreos pueden causar muchas muertes, pero mejoras como una lista de comprobación, un ordenador y un copiloto garantizan que no se produzca ninguna circunstancia imprevista, salvo las más descabelladas.

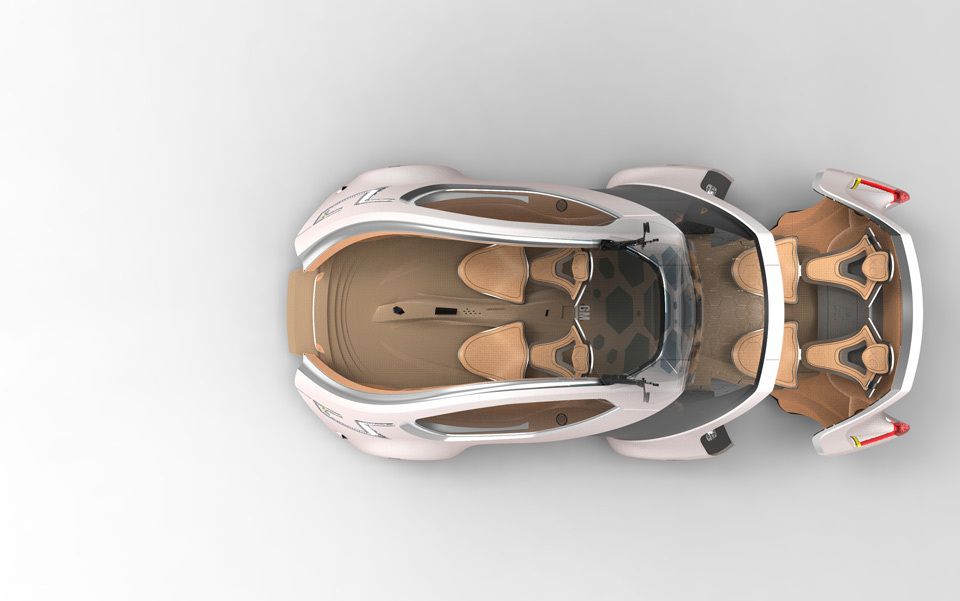

Refinamientos similares son el tema de uno de los debates más animados de la ética práctica actual: el caso de los coches autoconducidos. Los vehículos de motor modernos son más seguros y fiables que nunca, pero cada año mueren más de 1 millón de personas en accidentes de tráfico en todo el mundo, y más de 50 millones resultan heridas. ¿Por qué? En gran medida, porque un elemento peligroso de la mecánica de la conducción sigue sin ser perfeccionado por el progreso: el ser humano.

Entra en la vanguardia de la mitigación automática. En agosto de 2012, Google anunció que había recorrido 300.000 kilómetros sin accidentes probando sus coches autoconducidos. La tecnología sigue estando a cierta distancia del mercado, pero los argumentos estadísticos a favor de los vehículos automatizados son convincentes. Incluso cuando no causan lesiones, los coches controlados por humanos se conducen a menudo de forma ineficaz, inepta, antisocial o de otras formas que contribuyen a la suma de la miseria humana.

¿Qué ocurre, sin embargo, en contextos más locales? Si tu vehículo se encuentra con un autobús lleno de escolares derrapando por la carretera, ¿quieres vivir en un mundo en el que se desvíe automáticamente, a una velocidad que tú nunca habrías podido alcanzar, salvándolos pero poniendo en peligro tu vida? ¿O prefieres vivir en un mundo en el que no se desvíe pero te mantenga a salvo? Dicho así, ninguna de las dos parece una opción tentadora. Sin embargo, diseñar sistemas autosuficientes exige que resolvamos estas cuestiones. Y estas posibilidades nos llevan, a su vez, hacia uno de los experimentos mentales más candentes de la filosofía moderna: el problema del trolebús.

En su forma más simple, acuñada en 1967 por la filósofa inglesa Philippa Foot, el problema del trolebús imagina al conductor de un tranvía desbocado que se dirige por una vía. Cinco hombres trabajan en esta vía, y todos están seguros de morir cuando el trolebús les alcance. Afortunadamente, es posible que el conductor cambie la trayectoria del tranvía a un ramal alternativo de la vía, salvando a los cinco. Desgraciadamente, un hombre está trabajando en este ramal y morirá si se realiza el cambio.

En esta versión original, no es difícil decir lo que hay que hacer: el conductor debe hacer el cambio y salvar cinco vidas, aunque sea a costa de una. Si sustituyéramos al conductor por un programa informático, creando un carro totalmente automatizado, también le daríamos instrucciones para que eligiera el mal menor: matar a menos personas en cualquier situación similar. De hecho, podríamos preferir activamente que un programa tomara una decisión de este tipo, ya que siempre actuaría según esta lógica, mientras que un humano podría entrar en pánico y hacer lo contrario.

El problema del trolebús…

El problema del carrito se vuelve más interesante en sus abundantes variaciones. En un artículo de 1985, la filósofa del MIT Judith Jarvis Thomson propuso lo siguiente: en lugar de conducir un carrito desbocado, lo observas desde un puente mientras se precipita hacia cinco personas indefensas. Utilizar un gran peso es la única forma de detenerlo y, casualmente, estás junto a un hombre corpulento cuyo bulto (a diferencia del tuyo) es suficiente para lograr este desvío. ¿Deberías empujar a este hombre por el puente, matándolo, para salvar esas cinco vidas?

Un programa informático similar al que conduce nuestro primer tranvía no tendría ningún problema para resolver esto. De hecho, no vería distinción entre los casos. Si no hay alternativas, debe sacrificarse una vida para salvar cinco; dos vidas para salvar tres; y así sucesivamente. El gordo siempre debe morir: una forma de razonamiento ético llamada consecuencialismo, que significa que la conducta debe juzgarse en función de sus consecuencias.

Sin embargo, cuando se les plantea el problema del carrito de Thomson, muchas personas consideran que sería un error empujar al gordo a la muerte. Argumentan que el asesinato premeditado es intrínsecamente incorrecto, sean cuales sean sus resultados: una forma de razonamiento ético denominada deontología, que significa que la conducta debe juzgarse por la naturaleza de una acción y no por sus consecuencias.

La fricción entre la deontología y la deontología es que la conducta debe juzgarse por la naturaleza de una acción y no por sus consecuencias.

La fricción entre deontología y consecuencialismo es el núcleo de todas las versiones del problema del carrito. Sin embargo, tal vez la implicación más inquietante del problema no sea la existencia de esta fricción, sino el hecho de que -según cómo se cuente la historia- la gente suele tener opiniones muy distintas sobre lo que está bien y lo que está mal.

Presionar a alguien hasta matarlo es un delito.

Empujar a alguien a la muerte con tus propias manos es profundamente problemático desde el punto de vista psicológico, incluso si aceptas que teóricamente no es ni mejor ni peor que matarlo a 16 km de distancia. Mientras tanto, permitir que alguien a distancia -un niño hambriento en otro país, por ejemplo- muera por la inacción de uno apenas parece registrar un reparo. Como filósofos como Peter Singer han argumentado persuasivamente, es difícil ver por qué deberíamos aceptar esto.

G grandes mentes llevan milenios luchando con complejidades similares, quizá de forma más notable en la forma de la doctrina del doble efecto de Tomás de Aquino. Desarrollada originalmente en el siglo XIII para examinar la permisibilidad de la legítima defensa, la doctrina sostiene que tu intención al realizar un acto debe tenerse en cuenta cuando tus acciones tienen unas consecuencias buenas y otras perjudiciales. Así, si decides desviar un tranvía para salvar cinco vidas, tu intención principal es salvar la vida. Aunque una muerte resulte inevitable como efecto secundario, tu acto entra en una categoría diferente a la del asesinato premeditado.

La doctrina del doble efecto recoge una intuición que comparte la mayoría de la gente (y los sistemas jurídicos): conspirar para matar a alguien y luego hacerlo es un mal mayor que matarlo accidentalmente. Sin embargo, queda una pregunta incómoda: ¿hasta qué punto podemos confiar en las intuiciones e intenciones humanas? Como explora el escritor David Edmonds en su excelente nuevo libro ¿Matarías al Gordo? (2013), una serie de disciplinas emergentes han empezado a plantear sus propias reivindicaciones en torno a estos temas. Para el psicólogo Joshua Greene, director del Laboratorio de Cognición Moral de Harvard, la doctrina del doble efecto no es tanto una idea fundamental como una racionalización a posteriori.

En su último libro Tribus morales (2013), Greene reconoce que casi todo el mundo tiene una sensación instintiva de mal moral respecto a las personas que utilizan la fuerza personal para dañar a otra persona. Para él, este sentido moral instintivo es importante pero dista mucho de ser perfecto: un bocado de función cerebral profundamente arraigada del que difícilmente puede esperarse que siga el ritmo del progreso civilizatorio. Privilegia lo inmediato sobre lo lejano, y las acciones sobre las omisiones; no puede seguir cadenas complejas de causa y efecto. En otras palabras, es singularmente inadecuado para juzgar las acciones humanas amplificadas por el vasto aparato del comercio mundial, la política, la tecnología y la interconexión económica.

Aquí, los argumentos de Greene convergen con la ética de la automatización. Los seres humanos son como las cámaras, sugiere, en el sentido de que poseen dos modos morales: automático y manual. Nuestras emociones son “procesos automáticos… dispositivos para lograr la eficacia del comportamiento”, que nos permiten responder adecuadamente a los encuentros cotidianos sin tener que pensar en todo desde los primeros principios. Nuestro razonamiento, por su parte, equivale a un modo “manual”: “la capacidad de resolver deliberadamente problemas complejos y novedosos”.

Si puedes cuantificar la felicidad general con una precisión suficientemente pragmática, posees un cálculo capaz de atravesar por igual el bagaje biológico y las lealtades tribales

Se trata de un modo “manual”.

Es una dicotomía conocida por el trabajo del economista conductista Daniel Kahneman en Princeton. Sin embargo, a diferencia de Kahneman, Greene es optimista cuando se trata de superar los sesgos que la evolución ha incrustado en nuestro cerebro. Con un poco de perspectiva”, argumenta, “podemos utilizar el pensamiento en modo manual para llegar a acuerdos con nuestras “cabezas” a pesar de las diferencias irreconciliables de nuestros “corazones””. O, como dice más claramente la conclusión de Tribus Morales, debemos “cuestionar las leyes escritas en nuestros corazones y sustituirlas por algo mejor”.

Este “algo mejor” se parece más que un poco a un coche autoconducido. Al menos, se parece a la sustitución de nuestros propios circuitos por una pieza externa de automatización más eficiente. Al fin y al cabo, si la moralidad del sentido común es un maravilloso pero lamentablemente defectuoso trozo de maquinaria biológica, ¿qué mayor oportunidad podría haber que poner en marcha un nuevo código prístino, no lastrado por un cerebro desconcertado? Si puedes cuantificar la felicidad general con una precisión suficientemente pragmática, afirma Greene, posees un cálculo capaz de atravesar por igual el bagaje biológico y las lealtades tribales.

La automatización, en este contexto, es una fuerza que empuja los viejos principios hacia un punto de ruptura. Si puedo construir un coche que evite automáticamente la muerte de un autobús lleno de niños, aunque con gran riesgo para la vida de su conductor, ¿debería darse a cualquier conductor la opción de desactivar este ajuste? Y por qué detenerse ahí: en un mundo que cada vez podemos automatizar más allá de nuestros tiempos de reacción y razonamiento instintivo, ¿deberíamos confiar en nosotros mismos incluso para llevar a cabo una evaluación en primer lugar?

Más allá de la fricción filosófica, esta última pregunta sugiere otra razón por la que mucha gente encuentra inquietante el carro: porque su resolución consecuencialista presenta no sólo la posibilidad de que una acción éticamente superior pueda calcularse mediante un algoritmo (lo que no es en sí mismo una afirmación controvertida), sino también que el algoritmo correcto puede ser en sí mismo una entidad éticamente superior a nosotros.

Por el momento, las máquinas capaces de “pensar” en un sentido humano siguen siendo ciencia ficción. Sin embargo, cómo debemos prepararnos para su posible aparición es una cuestión profundamente inquietante, sobre todo porque las máquinas inteligentes parecen mucho más factibles que cualquier consenso sobre su programación o consecuencias.

Considera el triaje médico, un campo en el que la automatización y los algoritmos ya desempeñan un papel considerable. El triaje implica tomar decisiones que equilibren el riesgo y el beneficio en medio de un constante goteo humano de accidentes. Dado que el tiempo y los recursos son siempre limitados, un paciente al borde de la muerte puede tener prioridad sobre otro simplemente agonizante. Del mismo modo, si sólo se puede tratar al instante a dos de cada tres pacientes moribundos, se puede dar prioridad a los que tengan más probabilidades de salvarse con una intervención rápida; mientras que se puede desestimar a alguien que insista en que sus creencias religiosas significan que no se puede salvar la vida de su hijo.

En el campo de batalla, el riesgo y el beneficio son los mismos.

En el campo de batalla, el triaje puede significar dejar atrás a los heridos, si atenderlos pone en peligro la vida de otros. En salud pública, la cuarentena y la contaminación pueden implicar abandonar a unos pocos para proteger a muchos. Tales son los antiguos dilemas de la existencia colectiva, tareas que la tecnología y la investigación científica han hecho mucho más eficientes, eficaces y basadas en pruebas.

Si mi coche autoconducido está dispuesto a sacrificar mi vida para salvar otras muchas, este principio debería quedar claro de antemano, junto con sus parámetros exactos

.

¿Qué ocurre, sin embargo, cuando no nos limitamos a programar procedimientos cada vez más ágiles en nuestras herramientas, sino que las utilizamos para ayudar a determinar los principios que subyacen a estas decisiones en primer lugar: la ponderación del triaje, el momento en que se sellan automáticamente las puertas de una planta química en caso de crisis? En el otro extremo de la escala, podríamos preguntarnos: ¿deberíamos intentar valorar todas las vidas humanas por igual, externalizando nuestros ingresos y esfuerzos a la disciplina de la distribución equitativa de una IA? La fiscalidad es una solución defectuosa al problema; pero, con determinación e ingenio, los programas brillantes seguramente pueden hacerlo mejor. Y si las máquinas, en determinadas condiciones, son mejores que nosotros, ¿qué derecho tenemos a seguir errando en nuestras decisiones que probablemente sólo acaben mal para la especie?

Podrías dudar ante tales especulaciones. Sin embargo, es difícil saber dónde acabará la extrapolación. Al fin y al cabo, siempre necesitaremos máquinas que nos protejan de otras máquinas. En un momento dado, sólo la intervención de un dron artificialmente inteligente podría ser suficiente para protegerme de otro. Para el filósofo Nick Bostrom de Oxford, por ejemplo, lo que debería ejercitarnos no es un apego emocional al statu quo, sino más bien la cuestión de qué significa pasar con éxito a un marco de referencia sin precedentes.

En su artículo “La Ética de la Inteligencia Artificial” (2011), Bostrom y el teórico de la IA Eliezer Yudkowsky argumentaron que los algoritmos de toma de decisiones cada vez más complejos son inevitables y deseables, siempre que sigan siendo transparentes para la inspección, predecibles para quienes gobiernan y sólidos frente a la manipulación.

Si mi coche autoconducido está dispuesto a sacrificar mi vida para salvar la de muchos otros, este principio debe quedar claro de antemano, junto con sus parámetros exactos. La sociedad puede entonces debatirlos, poner un sello de aprobación (o no) a los resultados, y comenzar la siguiente fase de iteración. Puede que esté de acuerdo o puede que no, pero no puedo decir que no me hayan avisado.

¿Qué pasa en el peor de los casos? En lo que respecta a la automatización y la inteligencia artificial, los accidentes que se vislumbran en nuestro horizonte podrían no ser del tipo recuperable. Si nos equivocamos y consagramos prioridades contrarias al desarrollo humano en la primera generación de máquinas verdaderamente inteligentes, puede que no queden personas para recoger los pedazos.

A diferencia de nosotros, las máquinas no tienen una “naturaleza” consistente a lo largo del tiempo. Son, al menos al principio, lo que nosotros pongamos en marcha, con una tendencia innata hacia lo exponencial. Como ha señalado Stuart Armstrong, que trabaja con Nick Bostrom en el Instituto del Futuro de la Humanidad: si construyes un solo coche automatizado totalmente funcional, ya tienes la plantilla para mil millones. Sustituye a un trabajador humano por una inteligencia artificial de uso general y podrás extrapolar el desempleo total de la especie. Diseña un dron de vigilancia totalmente autónomo y tendrás un plan para controlar a perpetuidad a todos los hombres, mujeres y niños vivos.

En cierto sentido, todo se reduce a la eficacia y a lo dispuestos que estemos a que cualquier valor se persiga implacablemente en nuestro nombre. En la revista Harper’s del año pasado, el ensayista Thomas Frank analizó el panorama de las cadenas de restaurantes que rodean la mayoría de las ciudades estadounidenses. Cada establecimiento es un milagro de diseño modular, que resuelve la producción y venta de alimentos en una operación impecablemente optimizada. Sin embargo, señala Frank, el éxito del sistema en sus propios términos se produce a expensas de todas las cosas que se dejan de contar: las habilidades que no merece la pena enseñar a un trabajador para que las adquiera; los recursos que no es rentable proteger:

.

La construcción modular, la aplicación de las técnicas de la cadena de montaje al servicio de comidas, las freidoras de doble cesta y los dispensadores de condimentos a granel, incluso las ingeniosas tapas de plástico de los vasos de café, con sus lengüetas para sorber plegables: todo ello eran triunfos del ingenio humano. Había que admirarlos. Y, sin embargo, esa eficiencia intensa y concentrada también exigía un despilfarro fantástico en otros lugares: de combustible, de aire acondicionado, de tierra, de vertederos. Dentro de la caja había una obra maestra de la ingeniería industrial; fuera de la caja había cosas y personas que existían simplemente para ser utilizadas.

La sociedad ha estado saboreando los frutos de la automatización desde mucho antes de la revolución industrial y, tanto si eres un devoto utilitarista como un escéptico deontólogo, las ganancias en todos los ámbitos, desde el ocio y la riqueza hasta la productividad y la salud, han sido enormes.

A medida que la capacidad de acción deja de estar en manos de los seres humanos individuales, en nombre de diversas eficiencias, las pérdidas fuera de estas cajas no se evaporan simplemente hasta la inexistencia. Si nuestro destino es un nuevo tipo de aislamiento existencial -un mundo en el que los guardianes de las máquinas hagan imposibles ciertos daños y automáticos ciertos bienes-, no será porque hayamos triunfado sobre la historia y el tiempo, sino porque habremos delegado el compromiso en algo que está más allá de nosotros mismos.

El tiempo no es una máquina.

El tiempo no es, sin embargo, un problema que podamos resolver, por mucho que vivamos. En términos de Virilio, cada vida humana es un accidente a punto de ocurrir. Todos somos pasivos estadísticos. Si esperas lo suficiente, siempre acaba mal. Y aunque la felicidad agregada de la raza humana pueda ser una abstracción sumamente útil, incluso ésta acaba por no ser más que partículas insensibles y energía. No hay un conjunto cósmico de escalas a mano.

Donde antes el bien mayor era una frase, ahora se está convirtiendo en un objetivo que podemos poner en marcha independientemente de nosotros. Sin embargo, ni siquiera nuestras herramientas más brillantes tienen nada de trascendente. En última instancia, la medida de su éxito será la misma de siempre: los extraños accidentes de una vida humana.

”

•••

es autor y filósofo tecnológico, con especial interés en el pensamiento crítico. Su libro más reciente es Cómo pensar (2021). Vive en Kent (Reino Unido)

.