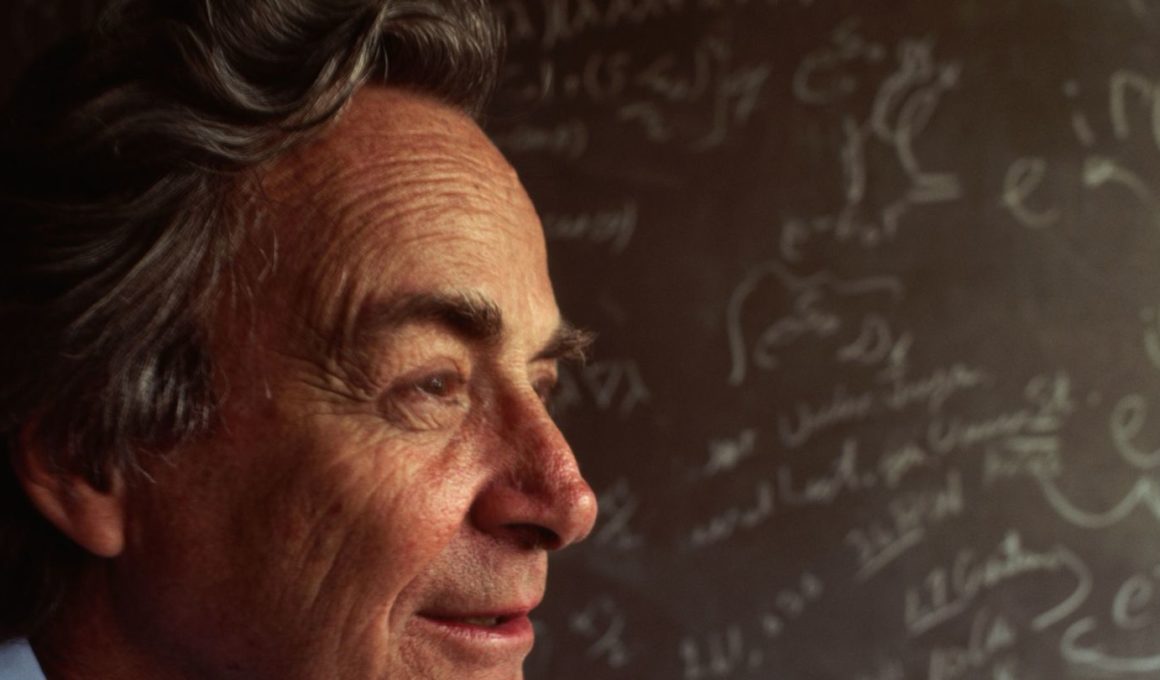

Richard Feynman fue un físico ganador del premio Nobel. Sin embargo, su verdadero superpoder era su capacidad para explicar temas complicados a los demás en términos sencillos. Se dio cuenta de que la jerga, las palabras vagas y la complejidad revelan una falta de comprensión.

Hay cuatro pasos clave en la Técnica Feynman:

- Elige un concepto que quieras aprender

- Explícalo a un niño de 12 años

- Reflexiona, afina y simplifica

- Organiza y revisa

Exploremos esto con más detalle para que puedas ponerlo en práctica hoy mismo.

Dos tipos de conocimiento

Feynman comprendió la diferencia entre entender algo y saber el nombre de algo, y es una de las razones más importantes de su éxito. Nunca se contentó con saber el nombre de algo. Quería comprenderlo a un nivel más profundo.

La persona que dice que sabe lo que piensa pero no puede expresarlo, normalmente no sabe lo que piensa.

— Mortimer Adler

La técnica Feynman

Paso 1: Elige un concepto sobre el que quieras aprender.

¿Sobre qué tema sientes curiosidad?

Una vez que identifiques un tema, saca una hoja de papel en blanco. Escribe todo lo que sepas sobre el tema que quieres entender, como si se lo estuvieras enseñando a un niño.

A medida que vayas aprendiendo más sobre el tema, añádelo a tu hoja. A menudo resulta útil utilizar un bolígrafo de distinto color para que puedas ver cómo crece tu aprendizaje.

Cuando creas que entiendes el tema, pasa al paso 2.

Paso 2: Explícaselo a un niño de 12 años

Ahora que crees que entiendes el tema razonablemente bien, explícaselo a un niño de 12 años.

Utiliza tu hoja como referencia e intenta eliminar cualquier jerga o complejidad. Utiliza sólo palabras sencillas. Utiliza sólo palabras que pueda entender un niño. (Si quieres un ejemplo de cómo hacer esto, consulta Things Explainer: Cosas complicadas en palabras sencillas. El libro utiliza las 1.000 palabras más comunes para explicar las cosas).

Cualquiera puede complicar un tema, pero sólo alguien que lo entienda puede hacerlo sencillo.

La jerga oculta nuestra falta de comprensión. Cuando te obligas a escribir una idea de principio a fin en un lenguaje sencillo, descubres dónde te cuesta… dónde no tiene sentido… dónde te frustras… dónde no entiendes realmente tan bien como creías. Sólo si identificas las lagunas de tus conocimientos podrás llenarlas.

Paso 3: Reflexionar, perfeccionar y simplificar

Sólo cuando puedas explicar el tema en términos sencillos lo entenderás.

Lo simple es hermoso.

Revisa tus apuntes para asegurarte de que no has tomado por error ninguna jerga ni has pasado por alto nada complicado.

Léelo en voz alta como a un niño. Si la explicación no es lo suficientemente sencilla o suena confusa, es un buen indicio de que necesitas reflexionar y perfeccionar.

Vuelve al material original, repasando las partes que aún no entiendes del todo.

Repite la operación hasta que tengas una explicación sencilla.

Paso 4: Organizar y revisar

Para poner a prueba tu comprensión en el mundo real, hazlo con otra persona. ¿Cómo de efectiva fue tu explicación? ¿Qué preguntas hicieron? ¿En qué partes se confundieron?

Cuando estés satisfecho con tu comprensión, coge la página que has creado con una explicación sencilla y ponla en una carpeta. Si sigues esta técnica para todo lo que aprendes, tendrás una carpeta llena de aprendizaje que podrás revisar un par de veces al año.

• • •

Las personas con más éxito del mundo pueden tomar temas complicados y explicarlos de forma sencilla (y memorable) a un público.

Entender esta técnica puede ayudarte a evitar que otros te engañen. La próxima vez que escuches a alguien explicar algo utilizando jerga o términos complicados, pídele que lo explique en términos sencillos. Si se frustran, es señal de que no entienden del todo de qué están hablando. Si lo hicieran, podrían explicarlo mejor.

La Técnica Feynman es la base de nuestro enfoque de “hoja en blanco” para potenciar la lectura y la retención.