“

En El origen de las especies (1859), Charles Darwin traza un cuadro del largo barrido de la evolución, desde el principio de la vida, desarrollándose a lo largo de dos ejes fundamentales: físico y mental. Cuerpo y mente. Todos los seres vivos, no sólo algunos, evolucionan por selección natural tanto en “dotaciones corporales como mentales”, escribe. Cuando la psicología haya aceptado esta visión de la naturaleza, predice Darwin, la ciencia de la mente ‘se basará en un nuevo fundamento’, el desarrollo evolutivo necesariamente gradual ‘de cada poder y capacidad mentales’.

Darwin supuso que la vida surgió de una única “forma” ancestral, presuntamente unicelular. Pronto, científicos de Alemania, Francia y Estados Unidos empezaron a investigar organismos microscópicos en busca de pruebas de “facultades mentales” (percepción, memoria, toma de decisiones, aprendizaje). Los tres grupos estaban dirigidos por hombres destinados a la eminencia. Dos de ellos -Alfred Binet, el psicólogo que ideó el primer test práctico de inteligencia, y Herbert Spencer Jennings, que sentó las bases de la genética matemática- se convencieron con sus investigaciones de que Darwin tenía razón: el comportamiento, incluso en los microbios, sugiere que existe una evolución tanto mental como física. Max Verworn, un gigante de la fisiología alemana, no estaba convencido.

Así se inició un acalorado debate sobre la continuidad de la evolución mental, la idea de que lo que en los humanos se denomina “mente” y en otros animales suele llamarse “cognición” se desarrolló y cambió a lo largo de millones de años (miles de millones, en realidad). Este debate continúa hoy en día. El auge del conductismo a principios del siglo XX, que privilegiaba el comportamiento observable como único dato científico admisible, cercenó el debate al dejar de hablar de mentes durante décadas. Cuando se inició la “revolución cognitiva” a mediados de siglo, la discontinuidad estaba firmemente establecida. El consenso era que, en algún momento de la evolución (y puede que nunca sepamos cuándo), la cognición -¡puf!- aparece de algún modo en algunos animales. Antes de eso, el comportamiento -el único indicador de cognición disponible sin lenguaje- habría sido totalmente innato, maquinal, reflexivo. Podría parecer cognitivo, pero no lo era. Este sigue siendo el punto de vista dominante, casi exclusivamente por su plausibilidad “intuitiva” basada en la comprensión del sentido común.

El filósofo Daniel Dennett, uno de los primeros filósofos cognitivos que invocaron la evolución, denominó a la selección natural “la idea peligrosa de Darwin” porque demostraba que la aparición de un diseño en la naturaleza no requiere un diseñador, divino o no. Como la mayoría de sus colegas, filósofos y científicos, Dennett no se creía la continuidad de la evolución mental. Sin embargo, mi opinión es que esta visión olvidada de Darwin fue su idea más radical, una idea con el potencial de inducir una auténtica revolución copernicana en las ciencias cognitivas y de transformar la forma en que vemos el mundo y nuestro lugar en él.

La revolución copernicana se basó en un único cambio de perspectiva. Durante 1.400 años, los eruditos europeos estuvieron de acuerdo con la gente corriente en que la Tierra era el punto inmóvil alrededor del cual giraban los cielos. El modelo ptolemaico del cosmos había establecido que el Sol, la Luna, las estrellas y los planetas se movían en esferas cristalinas anidadas alrededor de la Tierra. En 1543, Nicolás Copérnico publicó una alternativa detallada que sustituía la Tierra por el Sol. Al ponerla en movimiento alrededor del Sol con otros “errantes” celestes, nuestro planeta fue destronado como centro cósmico y nació la astronomía moderna.

De forma similar, la idea radical de Darwin destrona al cerebro humano y a otros cerebros de su posición “intuitivamente obvia” en el centro del universo cognitivo (occidental). En su lugar, Darwin coloca a un ser evolutivo y cognoscente que lucha por sobrevivir, prosperar y reproducirse en unas condiciones previsible e imprevisiblemente cambiantes. Este único cambio de perspectiva -desde un enfoque centrado en el cerebro, donde el Homo sapiens es el punto de referencia, a los hechos de la biología y la ecología- tiene profundas implicaciones. La recompensa es una explicación más precisa y productiva de un fenómeno natural ineludible, fundamental para comprender cómo nos convertimos en humanos y qué significa serlo.

¿Qué es la cognición? Como muchos conceptos mentales, el término no tiene una definición consensuada, hecho que enfureció a William James hace 130 años y a otros ocasionales desde entonces. Ésta es mi definición: La cognición comprende los medios por los que los organismos se familiarizan con las características de su entorno, las valoran, las explotan y las evaden para sobrevivir, prosperar y reproducirse. He aquí cómo llegué a ello.

Como estudiante de doctorado en Estudios Asiáticos hace 21 años, mi investigación se centró en cuatro proposiciones budistas que pretendía someter a un análisis filosófico y científico forense occidental. En estas proposiciones está implícita una visión budista muy sofisticada de la mente: qué es, cómo funciona, qué hace en condiciones inhumanas, qué puede hacer con entrenamiento y práctica. Busqué un comparador occidental en lo que entonces se llamaba ciencia cognitiva (en singular) y no encontré… nada.

Cuatro cartones de libros y un portátil lleno de artículos más tarde, tenía una colección de ideas sueltas y disonantes, y corrientes argumentales relacionadas, ninguna de las cuales aportaba una compra sobre la experiencia de tener una mente o su papel en el comportamiento. Como observó el neurobiólogo Steven Rose en 1998 (y no ha cambiado mucho), la neurociencia había generado océanos de datos, pero ninguna teoría que les diera sentido. En los albores del siglo XXI, esto me pareció escandaloso. Todavía me lo parece.

La ciencia cognitiva se regía entonces por tres marcos de referencia (con décadas de antigüedad) que proporcionaban los cimientos del paradigma cognitivista: 1) el cerebro humano; 2) la creencia de que el cerebro es una máquina de computación; y 3) la idea de que “la cognición es computación sobre representaciones”. Este último principio se resiste tenazmente a una explicación fácil porque los conceptos centrales introducen nuevas ambigüedades en el campo (como si hiciera falta alguna más). A grandes rasgos, se reduce a lo siguiente: hay cosas identificables en el cerebro que “representan” aspectos del mundo, de forma muy parecida a como lo hacen las palabras en las frases. Estos fragmentos de información se “procesan” según algoritmos aún por descubrir. Esto es lo que llamamos pensamiento, planificación, toma de decisiones, etc. No existe ninguna actividad mental por encima del procesamiento de las representaciones; la cognición sólo es este procesamiento.

La evolución había sentado las bases de las capacidades consideradas cognitivas mucho antes de que aparecieran los sistemas nerviosos

La biología y la evolución, que supuse que debían ser de suma importancia, estaban en gran medida ausentes; también lo estaban la fisiología, la emoción y la motivación. Los investigadores que creían que el estudio del comportamiento animal tenía algo útil que ofrecer a la ciencia cognitiva acababan de empezar a publicar en este campo y no fueron muy bien recibidos. La cognición “encarnada” y “situada” estaban ganando terreno, pero entonces eran más un reconocimiento de lo obvio sangrante que un marco coherente. Sin criterios de identificación, las atribuciones de la cognición biológica estaban por todas partes en la tienda taxonómica.

Sin embargo, seguía necesitando un comparador. Decidí investigar si la biología tenía las respuestas que yo suponía que debía tener. Opté por empezar por el rizoma del árbol de la vida, las bacterias, para ver si había algo concebiblemente cognitivo; 20 años después, sigo extrayendo este rico filón.

Mis primeras guías teóricas fueron las bacterias.

Mis primeros guías teóricos, recomendados por un biólogo australiano poco convencional, fueron el zoólogo Jakob von Uexküll y el neurocientífico Humberto Maturana. El concepto de Umwelt de von Uexküll (popularizado en inglés en 1934) me hizo apreciar la particularidad del mundo construido por el complemento único de sentidos de un organismo y el valor que el organismo atribuye a los elementos de esa construcción, evolucionado en función de cómo el organismo se gana la vida. El dióxido de carbono elevado es un atrayente para un mosquito que busca una comida de sangre, pero induce disnea transitoria, mareos y ansiedad leve en muchas personas (como ha demostrado la experiencia COVID-19 con el enmascaramiento). La Biología de la Cognición (1970) de Maturana me hizo darme cuenta de lo extraño que es el estado de vida en comparación con cualquier otro sistema físico de la Tierra.

Según Maturana, la vida se autoproduce, no sólo se autoorganiza o se automantiene. Si un Airbus A380 realizara la misma hazaña, podría buscar, tomar y transformar en combustible fuentes de materia y energía de su entorno y fabricar los componentes que le permiten funcionar (rodar, despegar, volar, mantener un entorno interior estable, tocar tierra) mientras vuela. Y eso sin hablar de la reproducción. La explicación de Maturana sobre la cognición se centra en la necesidad del organismo de interactuar continuamente con su entorno para lograr esta asombrosa hazaña. Este “dominio de interacciones” entre el organismo y el entorno es la cognición para Maturana, de modo que “vivir como proceso es un proceso de cognición” (cursiva del autor), una afirmación que he confirmado en bacterias de forma satisfactoria para mí.

La vida como proceso es un proceso de cognición (cursiva del autor).

El cognitivismo requiere efectivamente que la cognición-como-dominio-de-las-interacciones surja no antes del origen de los cerebros, y muy probablemente mucho después. En opinión de Maturana (y él era neurocientífico), el dominio cognitivo de las interacciones surgió con la vida unicelular. Las estructuras neuronales añadieron complejidad, tanto en el organismo cognitivo como en el entorno explotable, pero no generaron la cognición como tal. Las pruebas a favor del punto de vista de Maturana crecen día a día.

Conocimiento básico.

La cognición básica – el estudio de las capacidades cognitivas en organismos no neuronales y neuronales simples (al que condujo mi investigación doctoral) – está en su infancia como campo. Sin embargo, las pruebas ya demuestran que la evolución había sentado una base sólida de capacidades típicamente consideradas cognitivas mucho antes de que aparecieran los sistemas nerviosos: hace unos 500-650 millones de años. La percepción, la memoria, la valencia, el aprendizaje, la toma de decisiones, la anticipación y la comunicación -que en su día se consideraron exclusivas de la humanidad- se encuentran en una gran variedad de seres vivos, como bacterias, eucariotas unicelulares, plantas, hongos, animales no neuronales y animales con sistemas nerviosos y cerebros sencillos.

Sin embargo, ninguna prueba positiva de la cognición basal convencerá a un neurocentrista acérrimo. (¿Qué entiendes por memoria, valencia, toma de decisiones? ¿No es una cuestión de definición?) La idea radical de Darwin debe resolver problemas que el cognitivismo no puede resolver. El modelo copernicano no se convirtió en una revolución hasta que el modelo ptolemaico se enfrentó a descubrimientos que no podía predecir ni explicar, pero el modelo heliocéntrico sí. Para ello fueron necesarias las meticulosas y exhaustivas observaciones astronómicas de Tycho Brahe, las leyes del movimiento planetario de Johannes Kepler, la teorización de Galileo Galilei basada en observaciones ópticamente mejoradas y la ley de la gravitación de Isaac Newton, que se basó en el trabajo anterior (“los hombros de gigantes”). Llevó su tiempo: 144 años.

La tesis de Darwin sobre la continuidad de la evolución mental es más antigua que eso, pero está mucho más cerca del hueso de la identidad humana. Al fin y al cabo, “sabio” está en la designación latina de nuestra especie (el “sapiens” en H sapiens). Se supone que la posesión de una mente inteligente y racional es la característica que define a la humanidad. Aceptar un cosmos centrado en el Sol no es nada comparado con aceptar una psicología centrada en la vida. Sin embargo, puede que no tengamos elección.

La neurociencia cognitiva se enfrenta actualmente a varios retos que deben superarse para comprender cómo funcionan los cerebros y los sistemas nerviosos, requisito previo para entender cómo se generan las capacidades cognitivas en dichos sistemas. A continuación se esbozan tres de ellos. Lo que parece necesario en los tres casos son sistemas modelo más sencillos, a partir de los cuales es más probable que se realicen descubrimientos fundamentales sobre los impulsores de las interacciones de los organismos con su entorno. Dichos descubrimientos podrían conducir a principios generales que podrían ponerse a prueba en organismos más complejos.

El primer reto para la neurociencia se refiere a la “unidad funcional” del cerebro o sistema nervioso. Durante más de un siglo, la única célula nerviosa ha servido como unidad estructural y funcional de la actividad cerebral. Los pioneros de la ciencia cognitiva alistaron la doctrina de la neurona como fundamento de las supuestas capacidades computacionales del cerebro. Cada neurona se concebía como un interruptor de encendido y apagado supuestamente capaz de actuar como una puerta lógica, que permitía “digitalizar” la información (convertirla en unos o ceros) y, por tanto, “codificarla”. Se suponía que las neuronas individuales realizaban tareas de codificación complejas, incluso para lugares, caras y ubicaciones en el espacio; se concedió un Premio Nobel sobre esta base.

Los microbios pueden iluminar mecanismos cognitivos asociados normalmente con animales complejos

Dos descubrimientos han puesto en entredicho esta teoría. El primero es el número de tipos diferentes de células en el cerebro humano. Un reciente estudio reveló nada menos que 75 tipos de células diferentes: 24 tipos excitadores, 45 tipos inhibidores y seis tipos no neuronales. Lo que hacen todos ellos y cómo interactúan no se conoce bien. En segundo lugar, ahora está claro que las poblaciones de neuronas -que actúan en conjuntos, redes y/o circuitos- son las unidades más probables de la actividad funcional. Sin embargo, definir un conjunto, red y/o circuito neuronal no es trivial, como tampoco lo es comprender cómo se forman e interactúan, su estabilidad en el tiempo, si están anidados en jerarquías y cómo lo están, y cómo generan el comportamiento. Todos ellos son importantes trabajos en curso.

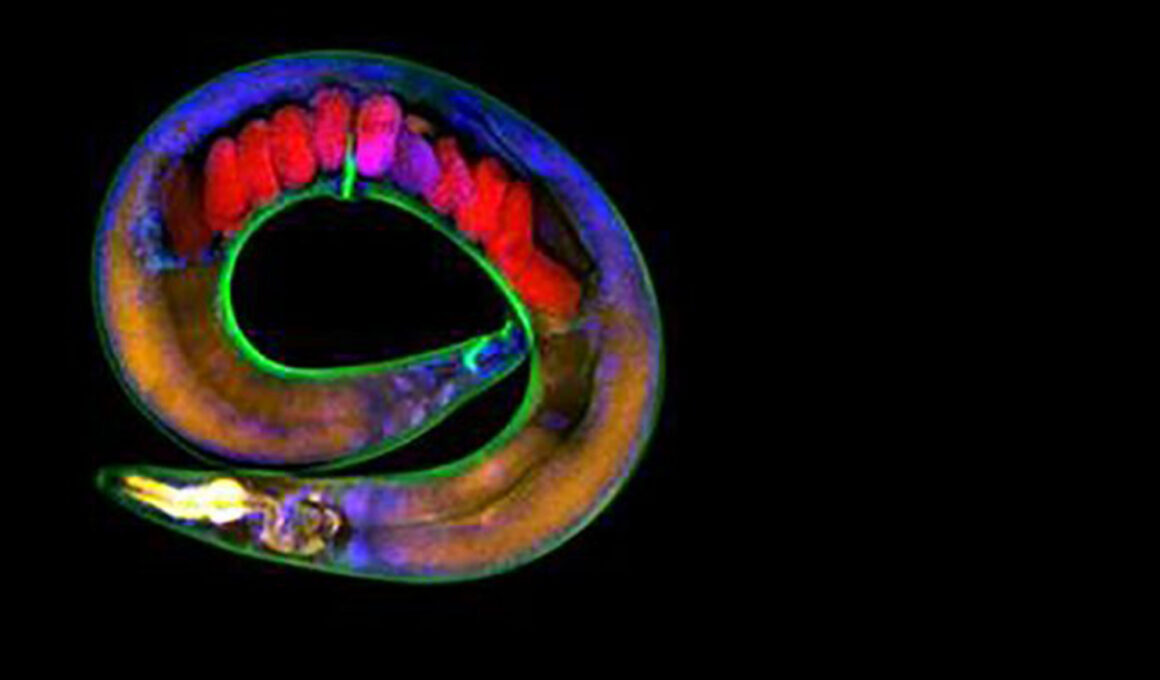

Para comprender cómo se forman y funcionan los circuitos neuronales es necesario que el organismo se comporte como un sistema completo. Por eso el neurocientífico Rafael Yuste introdujo la Hydra vulgaris, un animal de agua dulce con el sistema nervioso más simple que se conoce, como modelo para estudiar los circuitos neuronales. La decisión ha dado sus frutos. Toda la red nerviosa de la Hydra se ha visualizado simultáneamente -en vídeo – mientras el animal microscópico estira sus tentáculos para capturar comida y se contrae en forma de bola, lo que permite correlacionar distintos circuitos nerviosos con comportamientos diferentes. Gracias a las capacidades de Hydra regenerativas, ahora se ha identificado la secuencia paso a paso desde el crecimiento neuronal hasta la integración en todo el cuerpo de múltiples redes neuronales en animales regenerados a partir de células separadas. Sin embargo, el significado ecológico del comportamiento de Hydra sigue siendo poco conocido, y aún queda mucho trabajo por hacer para comprender para qué sirven (para el organismo) determinados comportamientos. Esto debería ayudar a esclarecer más la (bio)lógica dinámica de la actividad neuronal.

Aunque la idea de colectivos cambiantes de células cuya actividad coordinada requiere y puede constituir cognición no cuadra fácilmente con el principio cognitivista de “computación sobre representaciones”, su apoyo está muy extendido en biología. Los comportamientos complejos coordinados por miles de células autónomas interactuantes están bien estudiados en bacterias (por ejemplo, Bacillus subtilis, Myxococcus xanthus) y amebas sociales (Dictyostelium discoideum). El descubrimiento en B subtilis de colonias de señalización eléctrica a larga distancia a través de canales iónicos -el mecanismo de transmisión eléctrica en las neuronas- proporcionó la “prueba de concepto” de que los microbios pueden iluminar mecanismos cognitivos normalmente asociados a animales complejos. Este hallazgo condujo a otros descubrimientos de comportamientos bacterianos colectivos desconocidos hasta entonces que se asemejan a algunos tipos de actividad cerebral cognitiva, incluida la memoria. Los estudios sobre el comportamiento bacteriano mediado por la señalización eléctrica no han hecho más que empezar.

La actividad en red de las proteínas bacterianas de transducción de señales se describió por primera vez hace 25 años. Hoy en día, las propiedades de red de grandes conjuntos de proteínas de señalización, comunes en bacterias que dependen de flagelos en forma de látigo para navegar por gradientes químicos (quimiotaxis), son un área activa de investigación. Esta arquitectura, muy conservada a lo largo de la evolución, se ha comparado sólo un poco irónicamente con un “nanocerebro”, porque funciona como una red, es capaz de procesar grandes cantidades de información, es exquisitamente sensible a pequeños cambios en las condiciones ambientales y está situada en el polo principal de la célula, similar a la “cabeza” de la célula, pero que cambia de posición cuando la célula cambia de dirección.

El segundo reto para la neurociencia llegó cuando un heroico éxito científico reveló un “sorprendente fracaso”. Se completó el diagrama de cableado del cerebro de C elegans, un proyecto iniciado en el apogeo del cognitivismo. Se trazaron las conexiones entre las 302 neuronas del gusano y se definieron los comportamientos asociados a la mayoría de los tipos celulares. Sin embargo, este asombroso logro reveló poco sobre cómo y por qué un gusano se comporta como lo hace, que es el objetivo de la investigación. Según la neurocientífica Cori Bargmann, los estudios de C elegans “sugieren que no será posible leer un diagrama de cableado [neuronal] como si fuera un conjunto de instrucciones” para el comportamiento. Esto se debe a dos razones principales.

En primer lugar, el comportamiento en condiciones más realistas desde el punto de vista ecológico violaba los supuestos clave sobre la relación causal entre la actividad en neuronas concretas (p. ej., sensoriales, motoras, integradoras) y ciertos comportamientos (locomoción hacia delante y hacia atrás, alimentación) derivados de estudios de knock-out genético. Por el contrario, un mismo comportamiento puede ser inducido por varios circuitos neuronales diferentes. Además, el punto de partida de un circuito puede dar lugar a comportamientos distintos, incluso opuestos, en circunstancias diferentes.

La red del modo por defecto no es la única oscilación espontánea del cerebro

En segundo lugar, el contexto y el estado interno del organismo resultaron ser mucho más importantes para el comportamiento de lo que se pensaba inicialmente. Se cree que el contexto y el estado interno se señalizan mediante moléculas -los neuromoduladores y sus primos más pequeños, los neuropéptidos-, aunque no está claro cómo. Estas moléculas de señalización, muchas de las cuales son producidas por las propias neuronas, pueden alterar la función neuronal de segundos a minutos u horas; interactuar con diferentes objetivos (otras neuronas, células musculares, glándulas); y activar o silenciar circuitos enteros. C elegans produce más de 100 moléculas de este tipo.

En bacterias y eucariotas unicelulares (células con un núcleo definido, de las que carecen las bacterias), la actividad coordinada de miles de individuos -el equivalente al comportamiento multicelular- también se ve facilitada por moléculas de señalización, un fenómeno denominado detección de quórum. Las moléculas de detección de quórum se han comparado con las hormonas porque alteran el comportamiento mediante mecanismos similares. Al igual que hacen las hormonas en animales y plantas -y la actividad de los neuromoduladores y neuropéptidos no es distinta-, las moléculas de señalización producidas por las células microbianas inducen cambios en el comportamiento de cuatro formas: 1) en la célula productora; 2) en un vecino inmediato a través del contacto célula-célula; 3) dentro de vecindarios celulares; y 4) en células a mayor distancia. Existen muchas moléculas de señalización unicelulares, pero muchas menos que en los organismos pluricelulares.

El tercer reto para la neurociencia no fue un fallo de paradigma, sino que vino de fuera de campo. Los procesos cognitivos se concebían tradicionalmente como totalmente reactivos: algo en el mundo afecta al organismo (entrada), lo que da lugar a una respuesta (salida). La visión de entrada-salida es básica para el cognitivismo. El descubrimiento, a finales de la década de 1990, de la actividad cerebral espontánea y continua sin un estímulo externo se consideró inicialmente un artefacto de la tecnología de la imagen, luego profundamente desconcertante, y ahora es un importante campo de investigación. La red de modo por defecto se define como regiones cerebrales conectadas funcionalmente que están activas durante el reposo despierto e inactivas durante el comportamiento orientado a la tarea. Los chimpancés y los ratones presentan actividad de modo por defecto. En humanos, la alteración de la red por defecto se asocia a trastornos psiquiátricos. Esto significa que es importante para el funcionamiento cognitivo.

La red de modo por defecto no es la única oscilación espontánea del cerebro, ni mucho menos. El neurocientífico György Buzsáki, que ha trabajado duro para llamar la atención sobre los “ritmos del cerebro”, afirma que este tipo de actividad cerebral no es ruido del sistema, sino que “es en realidad la fuente de nuestras capacidades cognitivas” y podría ser el “organizador fundamental de la información neuronal” del cerebro. Se han detectado oscilaciones espontáneas de baja frecuencia en Hydra, pero también en una gran variedad de organismos, como plantas, eucariotas unicelulares y bacterias, así como en diversos animales. Si tales oscilaciones son organizadores centrales de la actividad viva – hipótesis de Alison Hanson, médico residente en el laboratorio de Yuste-, está claro que las neuronas no son necesarias para generarlas.

Las oscilaciones son producidas por canales iónicos de las membranas celulares que se encuentran en todo el árbol de la vida. El laboratorio de Michael Levin ha demostrado que la bioelectricidad generada por canales iónicos desempeña un papel clave en la “memoria de patrones” para regenerar cuerpos animales. Las planarias sin cabeza regeneran cerebros, a los renacuajos les vuelven a crecer colas, a las ranas adultas les vuelven a crecer extremidades posteriores funcionales (si se les induce), y la estimulación eléctrica puede hacer que crezcan cosas donde no deberían, por ejemplo, una segunda cabeza de gusano donde debería haber una cola. Para Levin, la aceptación pragmática de que incluso las células de los tejidos heredan algunas de las capacidades de toma de decisiones de sus antecesores unicelulares -lo que él denomina “la lente cognitiva”- podría transformar campos tan diferentes como la biología del desarrollo, la inmunología, la neurociencia, la bioingeniería y la inteligencia artificial.

Wlo que se necesita es un cambio de perspectiva. En El cerebro de dentro a fuera (2019), Buzsáki argumenta que muchos de los problemas aparentemente insolubles a los que se enfrenta la neurociencia surgen enteramente de “ideas construidas por el ser humano” sobre cómo debe funcionar la mente/cerebro, basadas en conjeturas filosóficas y científicas a lo largo de milenios, que luego se introducen con calzador en la actividad cerebral observada. Esto es lo que él denomina la perspectiva “de fuera a dentro”: “el marco dominante de la corriente principal de la neurociencia, que sugiere que la tarea del cerebro es percibir y representar el mundo, procesar la información y decidir cómo responder… de una manera “de fuera a dentro””. Esto es lo que Maturana llama “dependencia del observador”, desde el punto de vista del observador, no del sistema observado. El cerebro espontáneamente activo tiene su propia lógica, de la que no se comprende casi nada. Descifrar esta lógica desde la perspectiva del sistema que genera la actividad -de “dentro a fuera”- debería ser el objetivo principal de la neurociencia, sostiene Buzsáki, y no trasladar los supuestos humanos a las observaciones neuronales.

Hice una distinción similar hace 15 años. Llamé enfoque antropogénico (nacido en el ser humano) a la visión de la cognición basada en ideas originadas en la experiencia y la reflexión humanas, lo que Buzsáki denomina de fuera a dentro. Aunque el cognitivismo afirma que la cognición puede realizarse en distintas formas físicas (incluidos los robots), el enfoque sigue siendo antropogénico porque deriva de la capacidad humana de calcular números. El caso opuesto es lo que yo llamo el enfoque biogénico (nacido de la vida), que privilegia el modo biológico de existencia como fuente de la cognición y conlleva el punto de vista de dentro hacia fuera.

Si el objetivo es comprender la cognición humana, entonces el enfoque biogénico/desde dentro hacia fuera es el camino más prometedor para llevarnos más allá de este barajar geriátrico en un camino hacia ninguna parte. Dada la enorme inversión de fondos públicos y privados, por no hablar del ingenio humano, el tiempo y el esfuerzo de los últimos 70 años, ya deberíamos saber mucho más sobre qué es la cognición, para qué sirve y cómo funciona: teorías de estas cosas, no simples datos derivados de la actividad cerebral. Piensa en cómo se ha transformado la sociedad desde la década de 1950. ¿Cuántos dogmas se han estrellado y quemado? ¿Cuánto se ha aprendido en tantos campos?

Podemos vernos a nosotros mismos -con justificación científica- en un narciso, una lombriz de tierra, incluso en una bacteria

Se suponía que el Proyecto Genoma Humano iba a producir un “plano” genético. En cambio, cuando se publicó el primer borrador hace 21 años, nos enteramos de lo mucho que no sabíamos. Por ejemplo, hay demasiado ADN llamado “basura” para que sea realmente basura; los seres humanos compartimos una proporción sorprendente de genes con las plantas; y nuestro genoma lleva genes transferidos por organismos unicelulares. Al empezar a comparar cada vez más genomas completos, descubrimos que entre los genes compartidos con las plantas había algunos involucrados en los sistemas nerviosos centrales de los animales, incluidos nosotros. Además, un sistema entre los más críticos para la supervivencia humana -los mecanismos de defensa inmunitaria que operan de forma autónoma a nivel de células individuales- fue heredado de las bacterias o de su reino hermano, las arqueas, posiblemente hace miles de millones de años. ¿Qué tiene esto que ver con la cognición? Pues que resulta que el funcionamiento normal de la memoria y el aprendizaje depende de la interacción con las neuronas de elementos inmunoestimulantes (citoquinas). A. Real. Sorpresa. En la década de 1950 (y más tarde), el cerebro se consideraba inmunoprivilegiado; el sistema inmunitario no podía operar allí.

Sin embargo, aún no conocemos bien los fundamentos de la cognición: cómo funcionan juntos los sentidos para construir un mundo; cómo y dónde se almacenan a largo plazo los recuerdos, si permanecen estables y cómo lo hacen, y cómo los modifica su recuperación; cómo se toman las decisiones y se organiza la acción corporal; y cómo se evalúa la valencia.

La valencia es la capacidad de un cerebro para actuar de forma independiente.

La valencia es el valor que un organismo atribuye a las circunstancias que le rodean como ventajosas, amenazadoras o neutras. El papel central de la valencia en las emociones está bien establecido. En la actualidad existe consenso en que las emociones humanas intervienen fundamentalmente en la regulación del funcionamiento básico del organismo. Desde hace casi 50 años, sabemos que las bacterias migran hacia determinadas sustancias (ventaja) y tratan de eludir otras circunstancias (perjuicio). ¿Podría la comprensión de los mecanismos del comportamiento valioso bacteriano arrojar alguna luz sobre cómo las emociones generan el comportamiento en organismos más complejos? Nunca lo sabremos a menos que busquemos.

Al final de Origen, Darwin describe un “banco enmarañado” en el que las leyes de la selección natural actúan en la evolución y el comportamiento actual de plantas y animales que parecen tan diferentes entre sí como para no estar relacionados en absoluto, pero que no lo están, y que dependen unos de otros para la vida. A un nivel profundo, sugiere Darwin, todos los seres vivos están relacionados. Ahora lo sabemos de un modo que Darwin sólo podía imaginar, porque disponemos de herramientas incomparablemente más sofisticadas y de una comprensión mucho más rica de cómo funciona la evolución, que incluye la plasticidad del desarrollo, la epigenética y el cambio de todo el genoma, que proporciona -además de mutaciones de genes individuales- variación heredable sobre la que actúa la selección natural.

“Hay grandeza en esta visión de la vida”, escribe Darwin, y tiene razón. Ahora podemos vernos a nosotros mismos -con justificación científica y sin necesidad de superposiciones místicas o antropomorfismos- en un narciso, una lombriz de tierra, quizá incluso una bacteria, así como en un chimpancé. Compartimos orígenes comunes. Compartimos genes. Compartimos muchos de los mecanismos por los que nos familiarizamos con los mundos que crean nuestros sentidos y los valoramos. Todos luchamos por la existencia, cada uno a nuestra manera, dependientes unos de otros, esforzándonos por sobrevivir, prosperar y (para algunos) reproducirnos, en este planeta que compartimos, que no es el centro del Universo, ni siquiera del sistema solar, pero que es el único hogar que cualquiera de nosotros tiene.

Al igual que hemos llegado a pensar que nuestros cuerpos han evolucionado a partir de formas corporales más simples, ha llegado el momento de adoptar la idea radical de Darwin de que nuestras mentes también han evolucionado a partir de mentes mucho más simples. El cuerpo y la mente evolucionaron juntos y seguirán haciéndolo.

Este ensayo ha sido posible gracias a una subvención concedida a Aeon+Psyche por la Fundación John Templeton. Las opiniones expresadas en esta publicación son las del autor y no reflejan necesariamente los puntos de vista de la Fundación. Los financiadores de Aeon+Psyche no participan en la toma de decisiones editoriales.

”

•••

Es investigadora visitante interdisciplinar en el Instituto Southgate para la Salud, la Sociedad y la Equidad, de la Facultad de Medicina y Salud Pública de la Universidad Flinders de Adelaida. Actualmente está escribiendo un libro basado en las ideas de este ensayo.